La línea de texto de crisis más grande del Reino Unido para personas que necesitan apoyo urgente de salud mental le dio a investigadores externos acceso a millones de mensajes de niños y otros usuarios vulnerables a pesar de la promesa de no hacerlo nunca.

Shout, una línea de ayuda lanzada con una inversión de £ 3 millones de la Fundación Real del Duque y la Duquesa de Cambridge, dice que ofrece un servicio confidencial para personas que luchan para hacer frente a problemas como pensamientos suicidas, autolesiones, abuso y acoso.

Un Sección de preguntas frecuentes en su sitio web había dicho que si bien “anonimizados y agregados”, los “datos de alto nivel” de los mensajes se pasaban a socios académicos de confianza para que los investigaran y mejoraran el servicio, “las conversaciones individuales no pueden y nunca serán compartidas”.

Pero esa promesa se eliminó del sitio el año pasado, y desde entonces se ha dado acceso a conversaciones con millones de personas, incluidos niños menores de 13 años, a investigadores externos, el Observador ha encontrado.

Mental Salud Innovations, la organización benéfica que administra la línea de ayuda, dijo que todos los usuarios aceptaron los términos del servicio que permitían compartir datos con investigadores para estudios que “finalmente beneficiarían a quienes usan nuestro servicio y a la población en general”.

Pero los hallazgos han provocado una reacción violenta entre los expertos en privacidad, los especialistas en ética de datos y las personas que usan la línea de ayuda, quienes dijeron que el intercambio de datos planteaba preocupaciones éticas.

Se utilizaron más de 10,8 millones de mensajes de 271.445 conversaciones entre febrero de 2018 y abril de 2020 en un proyecto con el Imperial College de Londres destinado a crear herramientas que utilicen inteligencia artificial para predecir comportamientos, incluidos, por ejemplo, pensamientos suicidas.

Los identificadores personales, incluidos nombres y números de teléfono, se eliminaron antes de que se analizaran los mensajes, según Shout, que dice que los mensajes se habían “anonimizado”.

Pero los datos utilizados en la investigación incluyeron “conversaciones completas” sobre los problemas personales de las personas, según el estudio.

Parte de la investigación tenía como objetivo obtener información personal sobre los mensajes de texto de los usuarios, como su edad, sexo y discapacidad, para comprender mejor quién estaba usando el servicio.

Cori Crider, abogada y cofundadora de Foxglove, un grupo de defensa de los derechos digitales, dijo que dar a los investigadores acceso a los mensajes planteaba “serias cuestiones éticas”. “La confianza lo es todo en la salud, y sobre todo en la salud mental. Cuando comienza diciendo en sus preguntas frecuentes que “las conversaciones individuales no pueden y nunca serán compartidas”; y de repente pasas a entrenar IA en cientos de miles de ‘conversaciones completas’, has dejado atrás los sentimientos y expectativas de las personas vulnerables a las que atiendes”, dijo. “Es particularmente triste porque esto puede hacer retroceder años una investigación debidamente autorizada. La falta de confianza en estos sistemas puede disuadir a las personas desesperadas de presentarse”.

Otros expresaron su preocupación de que las personas que usaban el servicio no podían comprender realmente cómo se usarían sus mensajes en un punto de crisis, incluso si se les dijera que se usaría en una investigación, debido a su estado vulnerable. Alrededor del 40% de las personas que envían mensajes de texto a la línea de ayuda son suicidas, según Shout, y muchos son menores de 18 años.

Claire Maillet, de 30 años, que usó el servicio para recibir apoyo con ansiedad y un trastorno alimentario en 2019 y 2020, dijo que no tenía idea de que los mensajes pudieran usarse para investigación. “Tenía entendido que la conversación se mantendría entre la persona a la que estaba enviando mensajes y yo y no iría más allá”, dijo. “Si hubiera sabido que lo haría, entonces no puedo decir con certeza que aún habría usado el servicio”.

Maillet dijo que “entendía absolutamente” la necesidad de realizar investigaciones para “mejorar los servicios” en los casos en que las personas pudieran dar su consentimiento informado.

Pero dijo que usar conversaciones de una línea de ayuda para crisis generó preocupaciones éticas, incluso cuando se eliminaron los nombres, debido a la naturaleza de lo que se está discutiendo.

“Cuando estás en ese punto de crisis, no estás pensando, ‘¿Se usará esta información para investigación?’ Puedes girarlo de una manera que suene bien, pero se siente como si estuvieran explotando la vulnerabilidad de alguna manera”.

Phil Booth, coordinador de medConfidential, que hace campaña por la privacidad de los datos de salud, dijo que “no era razonable esperar que un joven o cualquier persona en crisis pudiera entender” que sus conversaciones podrían usarse para fines distintos a brindarles apoyo. . “Claramente, hay razones por las que Shout podría necesitar retener datos: nadie lo niega. Son estos otros usos: simplemente no son lo que la gente esperaría”.

Agregó que era “engañoso” y “claramente incorrecto” que la organización benéfica les hubiera dicho a los usuarios que sus conversaciones individuales no serían compartidas. “Si haces una promesa como esa, debes cumplirla”, dijo.

Shout se creó en 2019 como un legado de Heads Together, una campaña dirigida por el duque y la duquesa de Cambridge y el príncipe Harry con el objetivo de acabar con el estigma en torno a la salud mental. El objetivo del servicio es brindar apoyo de salud mental las 24 horas del día a las personas en el Reino Unido, muchas de las cuales luchan por acceder a los servicios del NHS sobrecargados, que pueden enviar un mensaje de texto a un número y recibir una respuesta de un voluntario capacitado.

Mental Health Innovations afirma que un objetivo clave es utilizar “datos agregados anónimos para generar información única sobre la salud mental de la población del Reino Unido”.

“Utilizamos estos conocimientos para mejorar nuestros servicios, para informar el desarrollo de nuevos recursos y productos, y para informar sobre tendencias de interés para el sector de la salud mental en general”, dice.

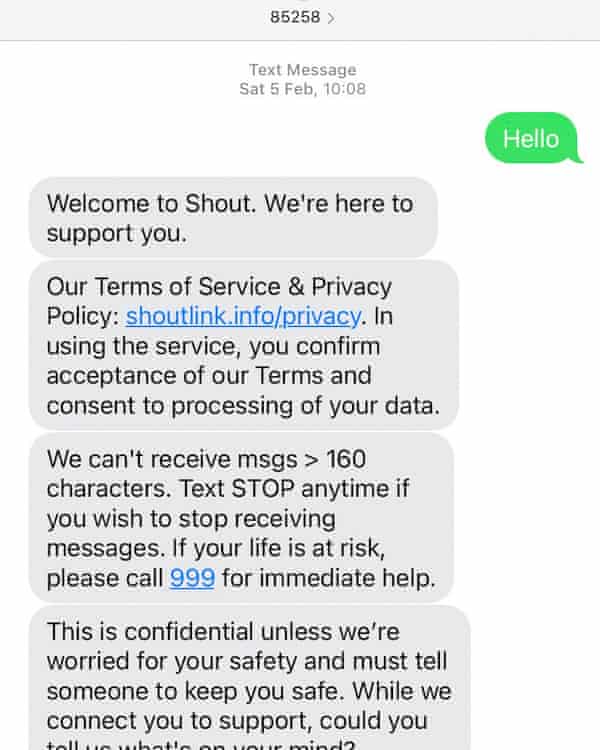

Cuando los usuarios del servicio se comunican por primera vez con Shout, se les dice: “Esto es confidencial a menos que estemos preocupados por su seguridad y debamos decirle a alguien que lo mantenga a salvo”. También se les envía un enlace a un texto con un enlace al sitio web y la política de privacidad con el mensaje: “Al usar el servicio, confirma la aceptación de nuestros términos y da su consentimiento para el procesamiento de sus datos”.

Sin embargo, las versiones anteriores de las preguntas frecuentes hicieron una promesa que desde entonces se eliminó, lo que significa que es probable que las personas que enviaron mensajes de texto al servicio en el pasado, incluidos aquellos cuyos mensajes se usaron en la investigación, hayan leído información que luego se modificó.

Una versión archivada del sitio web de la línea de ayuda de marzo de 2020 muestra que, en la sección de preguntas frecuentes, Se les dijo a los usuarios: “Anonimizamos y agregamos datos de alto nivel de las conversaciones para estudiar y mejorar nuestro propio desempeño. Compartimos algunos de estos datos con socios académicos cuidadosamente seleccionados y examinados, pero los datos siempre se anonimizan, las conversaciones individuales no pueden y nunca serán compartidas”.

A fines de la primavera de 2021, se actualizó la sección de preguntas frecuentes y se eliminó la promesa sobre conversaciones individuales. La política de privacidad también se actualizó para decir que, además de compartir datos, podría usarse para “permitir una comprensión más profunda del panorama de la salud mental en el Reino Unido en general”, abriendo la puerta a una gama más amplia de usos.

El estudio de Imperial, publicado en diciembre de 2021, involucró el análisis de “conversaciones completas” manualmente y utilizando inteligencia artificial, según el periódico. Para mejorar el servicio, tenía tres objetivos: predecir las etapas de conversación de los mensajes, predecir el comportamiento de los mensajeros y los voluntarios y “clasificar conversaciones completas para extrapolar información demográfica”, por ejemplo, escaneando mensajes en busca de cosas como números o menciones de la vida escolar. que podría indicar la edad de un usuario.

“Mirando hacia el futuro, nuestro objetivo es entrenar modelos para clasificar etiquetas que podrían considerarse directamente procesables o proporcionar una medida directa de la eficacia de la conversación. Por ejemplo, un objetivo futuro clave es la predicción del riesgo de suicidio de una persona que envía mensajes de texto”, escribieron los investigadores.

Los datos se manejaron en un entorno de investigación confiable y el estudio recibió la aprobación ética de Imperial, que dijo que la investigación “cumplía plenamente” con las “políticas de revisión ética estrictas” y proporcionó “percepciones cruciales”.

Pero la Dra. Sandra Leaton Gray, profesora asociada de educación en University College London, experta en los efectos de la tecnología en niños y jóvenes, dijo que como investigadora vio “muchas señales de alerta” con el uso de datos secundarios, incluido que no se solicitó el consentimiento de los padres.

El Dr. Christopher Burr, becario de ética y experto en inteligencia artificial en el Instituto Alan Turing, dijo que el análisis de datos responsable podría traer grandes beneficios. Pero dijo que no ser lo suficientemente claro con los usuarios sobre cómo se usarían las conversaciones confidenciales creó una “cultura de desconfianza”.

“Deberían estar haciendo más para asegurar que sus usuarios estén significativamente informados sobre lo que está pasando”, dijo.

Las preocupaciones sobre Shout siguen a una investigación en los EE. UU. realizada por el sitio de noticias Politico que expuso una asociación de intercambio de datos entre una organización benéfica de salud mental estadounidense y una empresa con fines de lucro.

Shout es la contraparte del Reino Unido de Crisis Text Line US, que se enfrentó a un intenso escrutinio a principios de este mes por sus tratos con Loris.AI, una empresa que promete ayudar a las empresas a “manejar sus conversaciones difíciles con los clientes con empatía”.

Después de que salieron a la luz los detalles de la asociación con Loris, Crisis Text Line cortó los lazos con la organización y se aseguró a los usuarios del Reino Unido que sus datos no se habían compartido con Loris.

Además de trabajar con investigadores académicos, Mental Health Innovations ha formado asociaciones con organismos privados, incluida Hive Learning, una empresa de tecnología.

Hive, cuyos clientes incluyen a Boots y Deloitte, trabajó con Shout para crear un programa de salud mental impulsado por IA que la firma vende a las empresas para ayudarlas a “mantener un cambio de comportamiento masivo a escala”. Es propiedad de Blenheim Chalcot, “el creador de empresas digitales líder en el Reino Unido”, que fue fundado por el fideicomisario de Shout, Charles Mindenhall.

Mental Health Innovations dijo que “no se habían compartido datos relacionados con conversaciones de mensajes de texto” con Hive y que su programa de capacitación fue “desarrollado con aprendizajes de nuestro modelo de capacitación de voluntarios”.

En un comunicado, la organización benéfica dijo que todos los datos compartidos con investigadores académicos, incluido Imperial, tenían detalles que incluyen nombres, direcciones, nombres de ciudades, códigos postales, direcciones de correo electrónico, URL, números de teléfono y identificadores de redes sociales eliminados, y afirmó que era “muy poco probable”. que podría estar vinculado a individuos.

Dijo que buscar el consentimiento de los padres antes de usar los datos en la investigación “haría que el servicio fuera inaccesible para muchos niños y jóvenes”, y agregó que entendía que los usuarios de mensajes de texto “desesperados por ayuda inmediata… pueden no ser capaces de leer los términos y condiciones que enviamos”. antes de que comiencen su conversación con nosotros”, pero que la política de privacidad permaneció disponible para que la leyeran en una etapa posterior. Si luego decidieran retirar el consentimiento, podrían enviar un mensaje de texto con la palabra “Loofah” al número de la línea de ayuda y se eliminaría su información, dijo una portavoz.

Victoria Hornby, directora ejecutiva de Mental Health Innovations, agregó que el conjunto de datos creado a partir de las conversaciones de Shout era “único” porque contenía información sobre “las personas en sus propias palabras” y podría generar enormes beneficios en la investigación de la salud mental.

Ella dijo que la promesa de que las conversaciones individuales nunca se compartirían estaba en las preguntas frecuentes, en lugar de la política de privacidad real, y se había eliminado del sitio web porque podría ser “fácilmente malinterpretado” debido a que hay “interpretaciones diferentes” de lo que son las “conversaciones individuales”. ” quiso decir. “No queríamos que se malinterpretara, así que lo cambiamos”, dijo.

los Oficina del Comisionado de Informaciónel organismo de control de protección de datos del Reino Unido, dijo que estaba evaluando la evidencia relacionada con el manejo de los datos de los usuarios por parte de Shout y Mental Health Innovations.

Una portavoz dijo: “Al manejar y compartir los datos de salud de las personas, especialmente los datos de los niños, las organizaciones deben tener más cuidado y establecer medidas de seguridad para garantizar que sus datos no se usen o compartan de formas que no esperarían. Evaluaremos la información y haremos averiguaciones sobre este asunto”.

En el Reino Unido e Irlanda, se puede contactar a los samaritanos llamando al 116 123 o enviando un correo electrónico a [email protected] o [email protected].